話題のAIエージェントの活用に重要なMCP(Model Context

最近、AIエージェントの活用が急速に進む中で、「MCP(Model Context Protocol)」という技術仕様が注目を集めている。本稿では、この概念を理解する手がかりとして、従来のAPI接続との違いに着目しながら、MCPの基本構造や今後の展望について整理する。

従来のLLMアプリケーション開発の課題

従来、LLM(大規模言語モデル)を用いたアプリケーション開発においては、RAG(Retrieval Augmented Generation)と呼ばれる枠組みが広く利用され、外部のデータソースやサービス、各種ツールとの接続が行われてきた。この際には主にAPIを介してシステム間を接続しており、多くのLLMがREST APIによるアクセスを提供している。開発者はJSON形式でプロンプトを送信し、同様に応答を受け取ることで処理を実現してきた。

しかし今後、AIが自律的に振る舞うエージェントとして機能し、さまざまなシステムと連携しながら情報を収集・判断・実行していく社会においては、個別にAPIを接続する方法では開発コストが高く、拡張性や相互運用性にも限界が生じる。そこで必要とされるのが、オープンかつ標準的な接続方式である。

MCPの登場とその意義

その要請に応えるかたちで、2024年末にAnthropic社が「Model Context Protocol(MCP)」をオープン標準プロトコルとして発表し、大きな注目を集めた。MCPは今後のAIエージェントの基盤となりうる概念である。

LLMの基本構造には二つの課題がある。第一に、LLMの内部知識には限界があるため、最新かつ広範な情報にアクセスできる仕組みが必要である。第二に、LLMが生成する出力があくまで「回答」にとどまり、現実世界で「行動」や「効果」をもたらすには不十分である。AIが実世界に作用するためには、LLMが適切な「ツール」を呼び出し、外部に働きかける必要がある。

MCPの基本構成と通信方式

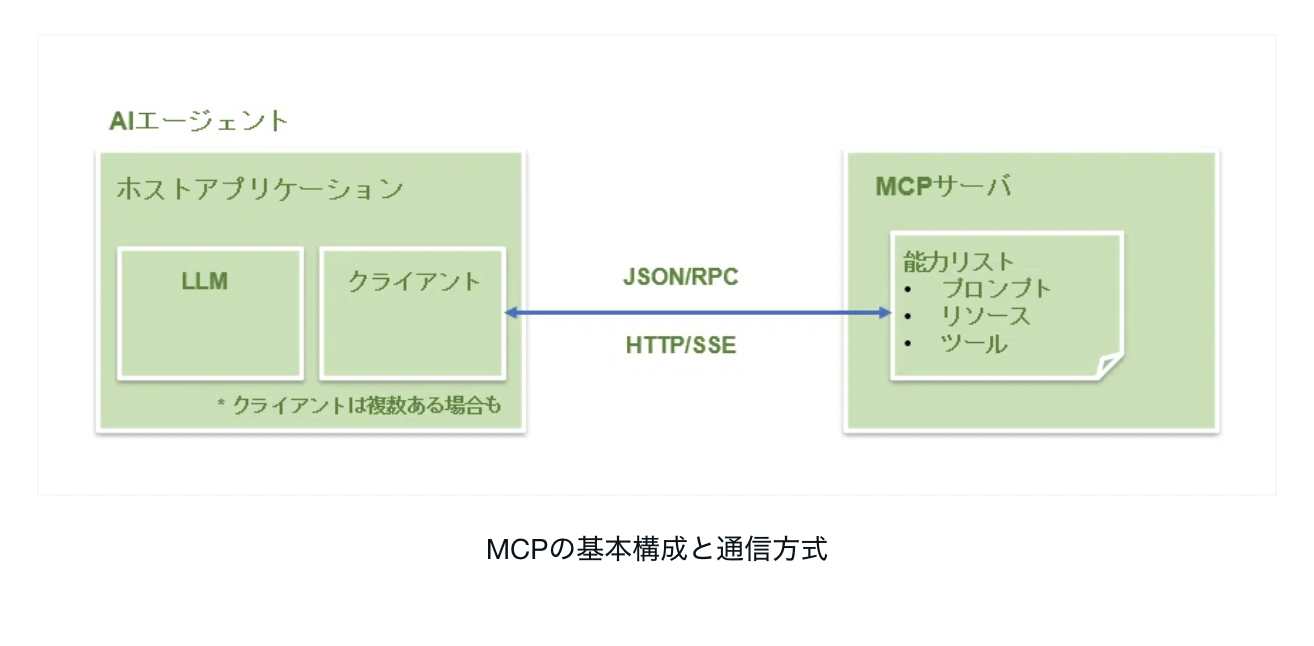

アーキテクチャの観点から整理すると、AIエージェントは自律的に動作するAIアプリケーションであり、多様なシステムやデータベース、ドキュメントにアクセスする。その起点となるアプリケーションは「ホストアプリケーション」と呼ばれる。ホストアプリケーションはMCPクライアント・ライブラリを利用して内部にクライアントを生成し、MCPサーバーと接続する。

MCPサーバーは一般公開されたサービスである場合もあれば、企業内に独自に構築される場合もある。サーバー内部にはプロンプト、リソース、ツールといった機能が備わり、AIエージェントからアクセス可能な形で提供される。

クライアントとサーバーの接続は、ネットワーク通信を通じて実現される。交換されるメッセージはJSON-RPC形式であり、クライアントが自身をサーバーにアナウンスして通信を確立するプロトコルが存在する。また、サーバーがクライアントに非同期的に通知を送信する仕組みも備わっており、双方向かつ柔軟な通信が可能である。

MCPの3つの基本要素

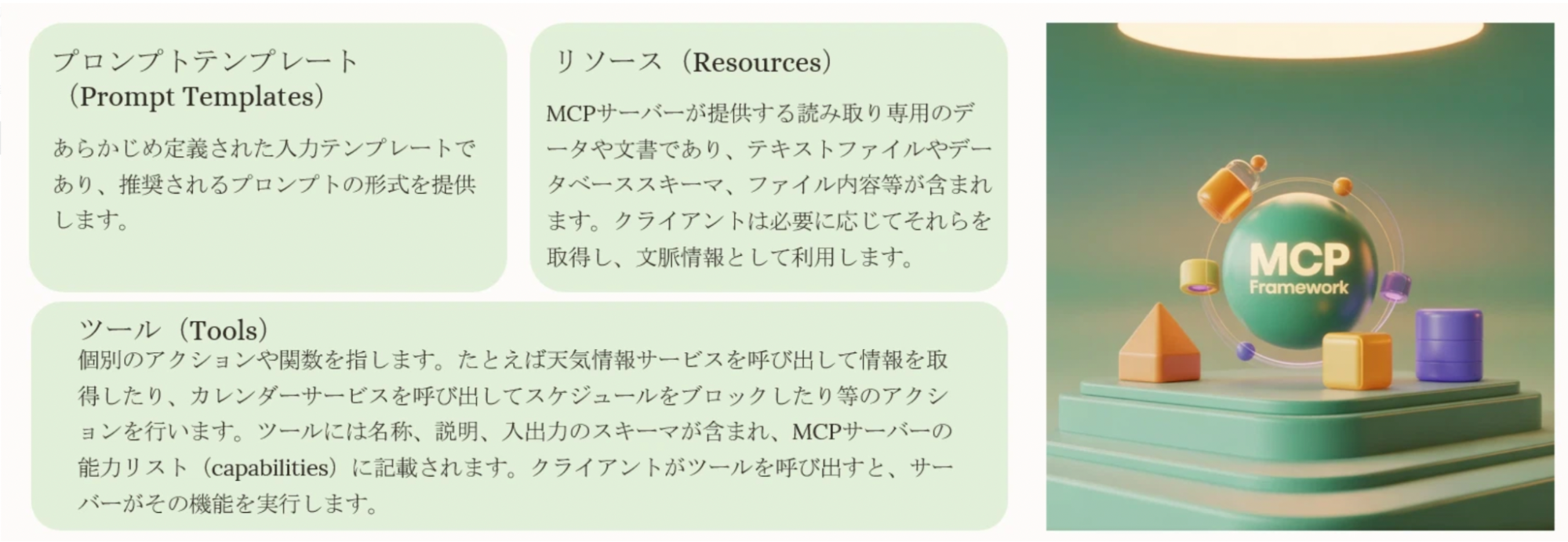

MCPサーバーは、3つの要素を「プリミティブ(基本単位)」として公開し、クライアントが動的に利用できるように設計されている。

プロンプトテンプレート(Prompt Templates)は、あらかじめ定義された入力テンプレートであり、推奨されるプロンプトの形式を提供する。これにより、開発者は毎回プロンプトを一から設計する必要がなくなる。

リソース(Resources)は、MCPサーバーが提供する読み取り専用のデータや文書である。テキストファイルやデータベーススキーマ、ファイル内容などが含まれ、クライアントは必要に応じてそれらを取得し、文脈情報として利用する。

ツール(Tools)は、個別のアクションや関数を指す。たとえば天気情報サービスを呼び出して情報を取得したり、カレンダーサービスを呼び出してスケジュールをブロックしたりする。ツールには名称、説明、入出力のスキーマが含まれ、MCPサーバーの能力リスト(capabilities)に記載される。

すべてのMCPサーバーがこれら三要素を備えているわけではないが、重要なのは、AIエージェントが実行時にMCPサーバーへ問い合わせることで、利用可能な機能を動的に発見できるという点である。

ワークフローの具体例

MCPを活用した実際のワークフローを考えてみよう。スケジュール調整サービスを構築する場合、予定を登録するためにはカレンダーへの招待作成が不可欠である。自分の空き時間を確認し、権限が許される範囲で相手の予定を参照する機能は「リソース」に該当する。利用可能なレストランやカフェといった飲食店情報もリソースの一部であり、これらがAIエージェントに文脈情報を与える。

一方で、予定を実際に作成する処理や、レストラン予約といった具体的な操作は「ツール」に分類される。もしAPIを直接AIエージェント内部に組み込む設計とした場合、それはそのエージェント専用の仕組みにとどまる。MCPの枠組みにおいてリソースやツールを定義し配置することで、それらは標準化された形で公開され、他のAIエージェントやアプリケーションからも利用可能になる。

MCPの拡張性

開発者は呼び出すツールの内部実装をすべて把握している必要はなく、MCPサーバーに登録されている機能であることが分かれば利用可能である。また、MCPサーバーが別のMCPサーバーを呼び出すことも可能である。例えば、AIエージェントが「レストラン情報用MCPサーバーX」にアクセスし、そのサーバーXが外部の専門サーバーYをツールとして登録していれば、AIエージェントはYに直接アクセスする必要はない。

このように、MCPの枠組みは拡張性と再利用性に優れている。結果として、プラグ適用性(pluggability)、発見可能性(discoverability)、構成可能性(composability)といった、ソフトウェア設計において望ましい特性を備えることができる。

普及状況と今後の展開

現在、MCPを利用する企業や開発者が世界中で増加しており、1万人以上のサーバービルダーが存在している。当初はローカル環境中心の運用が主であったが、現在ではクラウド上にMCPサーバーをホストする「リモートMCP」が台頭し始めている。

対応ソフトウェアに目を向けると、Anthropic社のClaudeや、Cursor、VS Code向けのエージェントであるClineなど、複数のホストアプリケーションがMCP対応を進めている。さらにSlack、Gmail、Notion、GitHub、Postgres、SQLiteなど、多様なMCPサーバー実装が公式およびコミュニティによって展開されている。

今後の大きな進展として注目されているのが、「レジストリAPI(Registry API)」の実装である。これは、LLM自身が必要に応じて追加のMCPサーバーを自律的に検索し、それらを取り込むことを可能にする仕組みである。これにより、AIエージェント自身が状況に応じて適切なサーバーを探索し、動的に文脈を拡張するような挙動が実現される。

また、「長時間実行タスク(long-running tasks)」への対応や、「情報引き出し(elicitation)」の仕組みも重要な進化ポイントである。後者は、MCPサーバーが必要な情報をユーザーに能動的に問い合わせる対話的機構を意味する。

まとめ

MCPは単なるAPI型のシステム間通信プロトコルにとどまらない。その先には、多様なAIエージェントが自律的に連携し、社会の多様なシステムと接続しながら価値を柔軟に実現していく未来像がある。現時点では安定性やセキュリティ確保といった課題が残されているが、MCPが共通インターフェースとして支持を得始めているのは確かであり、AIエージェントを中心とした新しいエコシステムの形成が加速していくことが期待される。

補足

ユーザーの目的によっては、単一のAIエージェントとMCPサーバ群の組み合わせだけでは十分でない場合がある。例えば旅行予約の場面を考えると、「フライト予約に特化したエージェント」と「ホテル予約に特化したエージェント」が既に存在しているとき、「旅行予約エージェント」が上位のエージェントとしてこれらを統合的に呼び出し、最終的な目的を達成することが望ましい場合がある。これはすなわち、AIエージェントのオーケストレーションの問題であり、このケースでは旅行予約エージェントがフライトエージェントやホテルエージェントをエージェント間通信(agent-to-agent call)によって利用する必要がある。

こうした仕組みを体系的に実現するためにGoogleが開発を進めているのが、エージェント間プロトコル(Agent2Agent Protocol = A2A)である。A2Aは、動的に連携する複数のエージェントから成るエコシステムを支える標準として設計され、パートナー企業や研究者と協力しながら整備が進められている。具体的には、エージェント間での能力の発見、タスクの割り当てと進捗管理、通信形式の標準化、文脈や結果の共有方法といった要素が定義される。MCPと同様に、A2Aも今後注目すべき枠組みであり、エージェントの発展を支える重要な基盤の一つになると考えられる。

-

森 正弥博報堂DYホールディングス執行役員Chief AI Officer、 Human-Centered AI Institute代表

森 正弥博報堂DYホールディングス執行役員Chief AI Officer、 Human-Centered AI Institute代表1998年、慶應義塾大学経済学部卒業。外資系コンサルティング会社、グローバルインターネット企業を経て、監査法人グループにてAIおよび先端技術を活用した企業支援、産業支援に従事。

東北大学 特任教授、内閣府AI戦略専門調査会委員、日本ディープラーニング協会 顧問。

著訳書に、『ウェブ大変化 パワーシフトの始まり』(近代セールス社)、『グローバルAI活用企業動向調査 第5版』(共訳、デロイト トーマツ社)、『信頼できるAIへのアプローチ』(監訳、共立出版)など多数。